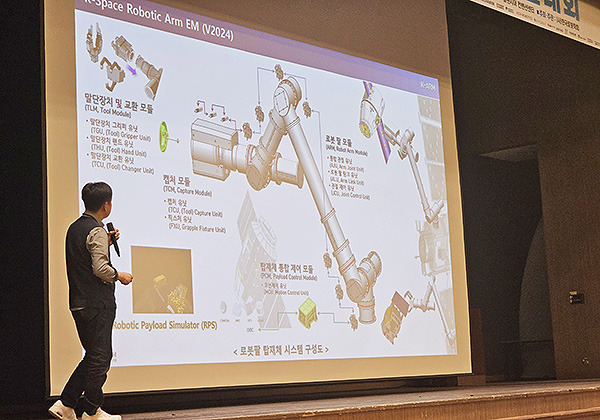

▲ 13일 평창 알펜시아 리조트에서 진행 중인 제 20회 한국로봇종합학술대회 현장에서 원대희 한국생산기술연구원 수석연구원이 한국형 우주로봇팔 개발 과정에 대해 설명하고 있다. (사진=전승민 기자)

12일부터 4일간 진행되고 있는 제20회 한국로봇종합학술대회(KRoC 2025)의 백미는 국내 정상급 로봇기술 전문가들이 펼치는 ‘초청강연’이다. 12일 워크숍 일정에 이어 진행된 13일 본 행사 첫 행사에선 개회식과 기조강연, 특별강연에 이어 총 5회의 초청 강연이 오후 내내 이어졌다. 다양한 인공지능(AI)을 비롯해 다양한 소프트웨어를 동원해 기존 로봇기술의 한계를 극복하려는 노력이 두르러져 보였다. 아래에 이날 진행된 주요 발표 내용을 간추려 소개한다.

◇고제성 아주대 교수 – 기계적 지능 기반 초소형 생체 모방 로봇

▲ 고제성 아주대 교수가 13일 평창 알펜시아 리조트에서 진행 중인 제20회 한국로봇종합학술대회에서 발표하고 있다(사진=전승민 기자)

고제성 아주대 기계공학과 부교수는 생체모방 로봇기술 분야에서 활약하고 있다. 이날 강연에서 고 교수가 강조한 것은 ‘지능적인 기계’다. 기존 로봇에 AI만 탑재하면 되는 것 아니냐 싶겠지만 고 교수의 개념은 전혀 다르다. 예를 들어 지능이 낮은 동물(벌레 등)이 어떤 동작을 할 때 지능적으로 생각을 하지 않는다는 것. 단지 생체 구조를 이용해 자연스럽게 지능적으로 행동할 뿐이다. 이런 구조를 로봇 원리에 적용하면 보다 효율적으로 동작하는 로봇을 만들 수 있다.

고 교수는 이날 강연에서 “버클리대에서 ‘바퀴벌레’를 연구한 것이 가장 대표적 사례”라면서 “바퀴벌레가 평지나 험지를 재빠르게 이동할 때 무슨 생각을 하지 않고 생체 구조를 이용해 이른바 ‘메커니컬 피드백’을 받으면서 빠르게 나아간다는 연구가 있다”고 설명했다.

곤충의 애벌레가 자유자재로 움직일 수 있는 이유도 비슷하다. 애벌레는 발밑에 많은 돌기가 있는데, 이런 돌기를 뻗어 주위 사물을 움켜잡으면 어디든 안정적으로 달라붙어 있을 수 있다. ‘지능이 있는 것이 아니라, 지능적인 구조를 갖고 있다’ 것이다. 고 교수는 “이런 구조를 살리면 안정적인 자동차 바퀴 구조 등을 만들 때 다양한 응용이 가능하다”고 했다.

고 교수는 이날 ‘소금쟁이’의 구조를 빌려, 물 표면을 박차고 오르는 ‘수면 도약 로봇’을 개발한 사례, 장갑 속에 구동장치를 넣어 사용자의 감각을 수용하는 장치 등을 개발한 사례 등을 소개했다. 그는 “다양한 생체모방 기술을 로봇 발전에 적용하기 위해 노력하고 있다”고 밝혔다.

◇원대희 생기원 연구원 – K-로봇, 지구에서 우주로!

▲ 원대희 한국생산기술연구원 수석연구원이 13일 평창 알펜시아 리조트에서 진행 중인 제20회 한국로봇종합학술대회에서 발표하고 있다(사진=전승민 기자)

이어진 강연에서 원대희 한국생산기술연구원 수석연구원이 ‘우주 로봇 개발’ 과정을 상세히 소개했다. 현재 진행 중인 한국형 ‘우주 로봇팔’ 개발 과정을 상세히 소개하며 관중들의 많은 관심을 얻었다.

국제우주정거장(ISS), 대형 우주왕복선 등에는 필수적으로 로봇팔이 설치되는데, 이 시장을 독점하다시피 한 회사가 캐나다의 ‘MDA’다. 캐나다의 로봇팔(ARM)이라는 의미에서 ‘캐나담’이라는 애칭으로 자주 불린다. 원 연구원은 “우주 로봇팔은 캐나담이 대표적이지만, 주로 ISS 등에서 자주 쓰인다”며 “소형 인공위성이나 우주탐사선에 설치될 소형 로봇팔도 필요하다고 여겨져 이 분야 연구를 지속하고 있다”고 소개했다.

원 연구원에 따르면 우주 쪽에서의 로봇 활용이 대단히 높아지고 있다. 1년에도 몇십 개씩 우주발사체가 지구 밖으로 나가고 있으며, ISS 등에 도킹하는 것은 물론 중소형 인공위성간에 로봇팔로 붙잡고 서로 도킹하는 등의 작업 수요가 점점 높아지고 있다.

원 연구원은 “우주쓰레기 600㎏짜리가 자연적으로 지구로 떨어지려면 100년 이상이 필요하다”며 “우주쓰레기를 강제로 붙잡아 낙하시키는 ‘우주청소사업’ 등 분야가 성장하고 있어 우주로봇팔 개발은 수요가 있다”고 했다.

원 연구원은 현재 생기원에서 진행 중인 우주 로봇팔 연구 사례를 다양한 사진과 함께 상세히 소개했다. 그는 “지구와 우주의 환경이 전혀 다르다”면서 “중력의 영향이 없는 상황을 고려한 ‘중력보상 이론’을 만들어 실험해야 하는 점, 우주 방사선 등 다양한 악조건을 극복해야 하는 점 등 다양한 어려움이 있다”고 했다.

원 연구원은 우주 로봇팔 기술 발전을 위해선 항공우주분야 시스템 전문가들과 협력이 절실하다고 지적했다. 그는 “우주에선 로봇팔을 움직일 때, 로봇이 장착된 위성 몸체도 움직인다”며 “위성 전체를 한 대의 시스템으로 보는 개념, 즉 로봇의 전신제어(Wholebody control) 개념에서 연구를 해야 한다”고 밝혔다.

◇박동일 기게연 센터장 – 고난도 수작업 대체를 위한 고난도 머니퓰레이션 기술

▲ 박동일 한국기계연구원 첨단로봇연구센터장이 13일 평창 알펜시아 리조트에서 진행 중인 제20회 한국로봇종합학술대회에서 발표하고 있다(사진=전승민 기자)

공장에서 사람과 함께 일하는 로봇은 여러 종류가 있는데, 이상적인 형태로 꼽히는 것이 사람처럼 두 손을 모두 써서 일할 수 있는 ‘양팔형 로봇’이다. 한국형 산업용 양팔로봇 중 대표적인 개발 사례가 한국기계연구원에서 2016년 개발한 ‘아미로’다. LG전자 휴대전화 사업부와 협력하며 실제 산업 투입을 목표로 했다. 상용화는 이뤄지지 않았지만 당시 연구한 내용이 다양한 로봇개발로 이어지면서 국내 로봇 기술 발전의 한 획을 그었다.

박동일 기계연 첨단로봇연구센터장은 아미로 개발을 비롯해 기계연의 다양한 로봇기술 개발을 총괄해 온 인물로 꼽힌다. 박 센터장은 이날 강연에서 아미로 개발 사례부터 현재까지 이어진 기계연 로봇기술 개발의 역사를 상세히 소개했다. 그는 “아미로에서 시작해 120㎏ 무게의 짐을 옮길 수 있는 대형 양팔로봇 등을 개발했고, 공장 등에서 정밀하게 작업할 수 있는 다양한 로봇팔 제작기술로 이어졌다”면서 “공장에서 실제로 사람 대신 물품을 조립하는 로봇기술을 다양한 분야에서 연구하고 있다”고 소개했다.

박 센터장은 연구 중 가장 어려웠던 부분에 대해 “단단한 물건은 어떻게 해서든 로봇손으로 옮길 수 있는데, 말랑말랑한 물건, 특히 제품 생산과정에서 반드시 필요한 케이블(전선) 등을 엮고, 연결하는 등의 작업은 거의 불가능해 보인다”며 “이런 경우는 로봇에서 해결 할 문제가 아니라 공정 전체를 새롭게 설계해야 한다고 보고 해당 기술을 개발 중”이라고 소개했다.

박 센터장은 이밖에도 기계연 첨단로봇연구센터에서 개발 중인 다양한 로봇을 소개했다. 2022년 소개됐던 계단등반로봇, 2023년 소개됐던 장애인용 ‘투휠(Two Wheel) 기반 로보틱 휠체어’ 등에 대해 소개하며 “앞으로는 이런 기술을 모두 종합해 휴머노이드(인간형) 로봇 플랫폼으로 발전시켜 나갈 계획”이라고 소개했다.

◇윤국진 KAIST 교수 – Visual Sensing and Perception for Autonomous Driving

▲ 윤국진 한국과학기술원 교수가 13일 평창 알펜시아리 조트에서 진행 중인 제20회 한국로봇종합학술대회에서 발표하고 있다(사진=전승민 기자)

자율주행차는 기술적으로 로봇의 한 형태로 볼 수 있다. 특히 주위 상황을 카메라, 라이다(Lidar; 레이저측정기), 레이더(Radar), 초음파 센서 등의 장치로 인식하는 ‘센싱’ 기술은 자율주행차 분야에서 가장 요구가 크다. 윤국진 한국과학기술원(KAIST) 기계공학과 교수는 해당 분야 전문가로 다양한 연구 경험을 갖췄다. 이날 강의에서도 자율주행차 개발에 필요한 다양한 센싱 기술 전반에 대해 소개했다.

윤 교수에 따르면 자율주행차는 주로 카메라를 이용한 ‘비전(Vision)’ 기술을 많이 이용하지만, 그 밖에도 다양한 센서를 두루 이용한다. 이 과정에서 센서를 복합적으로 활용하는 과정에서 다양한 응용이 가능하다. 크게 △한 가지 센서만 이용하거나(독립센서 방식) △여러 개의 센서를 두루 이용하거나(복합센서 방식) △기존에 없던 새로운 센서를 활용하거나(신형센서 도입) △센서에서 오는 정보를 취합하는 방법론을 수정하는(알고리듬 개선) 4가지 방법론이 존재한다.

윤 교수는 이런 네 가지 방법론을 두루 설명하면서 “시각(카메라) 정보만 이용하면 야간, 악천후 등의 상황에서 아무래도 한계가 있다”면서 “복합센서 이상의 방식이 필수적이며, 이 과정에서 새로운 방법론이 태어나기도 한다”고 설명했다. 예를 들어 레이저를 이용하는 라이다와 전파를 이용하는 레이더, 두 개의 센서를 동시에 이용하는 방식이 존재한다. 그런데 이 방법론을 그대로 가지고 와, 라이다 한 가지 센서로 마치 두 개의 센서를 이용하는 것처럼 알고리듬을 짜 봤더니 도리어 성능이 더 높아지는 경우가 있었다는 것이 윤 교수의 설명이다.

최근 센서를 통해 받은 데이터를 입력받은 하나의 거대한 네트워크가 동작해 조향각, 속도, 제동의 출력을 내는 ‘엔드 투 엔드(End to end)’ 방식이 주목 받고 있다. 윤 교수는 “이 과정에서 과거에는 필요 없다고 여겨지던 다양한 중복정보(Redandancy)를 활용하는 것도 중요해지고 있다”면서 “이를 어떻게 활용할지를 찾아가는 연구가 필요한 시점”이라고 소개했다.

◇최종현 서울대 교수 – Understanding sequences of visual data

▲ 최종현 서울대 교수가 13일 평창 알펜시아 리조트에서 진행 중인 제20회 한국로봇종합학술대회에서 발표하고 있다(사진=전승민 기자)

인간처럼 자연스럽게 주변 환경과 반응하는 로봇을 개발하려면 AI의 도입은 필수적이다. 특히 로봇이 사람처럼 주변 환경을 인식하고 스스로 주어진 미션을 실행하도록 만들기 위해선 ‘AI가 영상을 이해하는 능력’은 반드시 필요하다.

최종현 서울대 전기정보공학부 교수는 해당 분야 대표적 연구자로 꼽힌다. 최 교수는 “흔히 알프레드(ALFRED) 등의 가상환경에서 실험하는 경우가 많고 우리도 이런 플랫폼에서 연구를 많이 했다”고 소개했다.

연구 방식은 가상환경 속에서 주어진 미션을 실행하는 것이다. 예를 들어 ‘왼쪽 소파에 있는 방석을 집어서 오른쪽 소파 위로 올려 놓아라’라고 명령하면, AI가 이 명령을 알아듣고 주위 상황을 스스로 인색해 판단하면서 일을 해야 한다. 즉 시뮬레이션 된 환경에서 목표지향적 작업을 수행하는 ‘에이전트’를 개발하는 과정으로 이해할 수 있다.

이런 명령을 사람이 마우스와 키보드로 수행하면 당연히 90%가 넘는 성공률을 보인다. 그런데 AI 모델에게 지시할 경우, 과거엔 성공률 0.5%면 대단히 높은 경우다. 최 교수는 “다양한 AI 영상해석 기법, AI 학습법을 동원하고 주위 상황 인식, 명령방식을 개선하는 방식으로 성공률을 높여왔다”면서 “네비게이션 알고리듬을 개발하는 등의 과정에서 이런 접근이 큰 도움이 될 수 있다”고 소개했다.

전승민 기자 enhanced@irobotnews.com

<저작권자 © 로봇신문사 무단전재 및 재배포금지>

'전문서비스로봇' 카테고리의 다른 글

| 中 특수 로봇기업 '퀀텀인텔리전스', 80억원 규모 시리즈 A 투자 유치 (0) | 2025.02.17 |

|---|---|

| 한화로보틱스, 고속도로에 조리로봇 도입 (0) | 2025.02.16 |

| 中 유니트리, 온라인서 휴머노이드 로봇 판매 개시 (1) | 2025.02.14 |

| 덴마크 카프라 로보틱스, 종잣돈 169억원 유치 (1) | 2025.02.14 |

| 도구공간, 현대건설과 함께 스마트시티 순찰로봇 실증사업 완료 (0) | 2025.02.13 |