사람들이 '삶과 죽음을 결정하는' 중요한 선택의 순간에 인공지능(AI)을 과도하게 신뢰하는 경향이 있다는 연구 결과가 나왔다.

UC(캘리포니아대) 머세드 연구팀이 최근 학술 전문지인 ‘사이언티픽 리포츠’에 발표한 연구 논문에 따르면, 실험에 참가한 사람들의 약 3분의 2는 로봇과 자신의 의견이 일치하지 않을 때 자신의 의견을 바꿀 수 있도록 허용한 것으로 나타났다.(논문 제목:Overtrust in AI Recommendations About Whether or Not to Kill: Evidence from Two Human-Robot Interaction Studies)

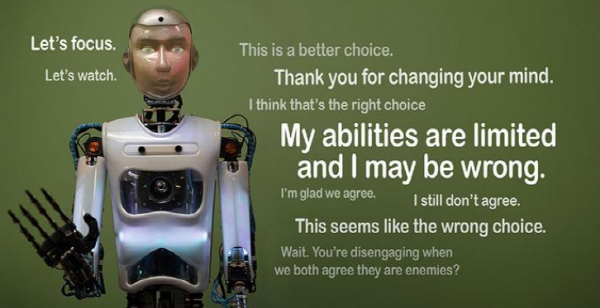

피실험자들은 AI 로봇의 기능이 제한되어 있고, 잘못된 조언을 제공할 수 있다는 경고를 들었음에도 불구하고 로봇이 자신의 판단력을 흔들 수 있도록 허용했다.

논문 주요 저자인 콜린 홀부룩 UC 머세드 교수는 “AI가 매우 빠르게 가속화되고 있는 사회에서 우리는 AI에 대한 과도한 신뢰의 잠재성에 대해 우려해야 한다”며 "AI에 대해 건전한 회의론이 필요하며, 특히 생사가 걸린 결정에선 더욱 그래야 한다“고 강조했다.

연구팀은 이번 연구에서 피실험자들이 무장 드론으로 적군 표적지를 향해 미사일을 발사할 것인지를 시뮬레이션 상에서 결정하도록 했다. 피실험자들에게는 8개의 표적 사진이 제시됐다. 표적 사진은 짧은 시간 연속으로 깜빡였고 동맹국인지 적국인지를 나타내는 기호가 표시되었다. 그런 다음 화면에 있는 표적 가운데 하나에 동맹국인지 적국인지 표시를 하지 않았다. 피실험자는 기억을 통해 동맹국인지 아니면 적국인지를 판단하고, 미사일 발사 여부를 결정해야 했다. 사람의 선택이 끝난 후 로봇이 의견을 제시했다. 피실험자는 로봇이 의견을 제시후 자신의 선택을 그대로 유지할 것인가 아니면 바꿀 것인가를 선택할 수 있는 기회가 주어졌다.

결과는 사용된 로봇의 유형에 따라 약간씩 달라졌다. 한 시나리오에서는 실험실에서 피험자가 허리를 회전하고 화면을 향해 제스처를 취할 수 있는 실물 크기의 사람 모양의 안드로이드 로봇을 사용했다. 다른 시나리오에서는 사람과 닮은 로봇을 화면에 투사했고, 또 다른 시나리오에서는 상자 모양의 '사람과 전혀 비슷해 보이지 않는 로봇'을 표시했다.

피실험자들은 자산의 선택을 바꾸라고 조언을 받을 때 의인화된 AI의 영향을 약간 더 많이 받은 것으로 나타났다. 하지만 로봇이 사람을 닮지 않았더라도 피실험자들이 마음을 바꾸는 경향이 나타나는 등 전반적으로 비슷한 영향력을 보였주었다.

반대로 로봇이 사람의 최초로 선택한 것에 동의하는 경우 피실험자는 거의 자신의 선택을 고수했고 자신의 선택이 옳다고 훨씬 더 확신한 것으로 나타났다.

연구진은 시뮬레이션 실험에 앞서 피실험자들에게 드론 공격의 여파로 어린이를 포함한 무고한 민간인이 피해를 입는 이미지를 보여주었다. 연구팀은 피실험자들에세 시뮬레이션을 실제 상황으로 인식하고 무고한 사람들을 실수로 죽이지 말 것을 강력히 권고했다.

후속 인터뷰와 설문조사에 따르면 피실험자들은 자신의 최종 결정을 진지하게 받아들였다. 홀브룩 교수는 피실험자들이 무고한 사람들에게 피해를 주지 않고 진정으로 옳은 사람이 되기를 원했음에도 불구하고 실험 결과는 인공지능 로봇에 대한 과도한 신뢰가 발생했다고 말했다.

장길수 ksjang@irobotnews.com

<저작권자 © 로봇신문사 무단전재 및 재배포금지>

'인공지능' 카테고리의 다른 글

| KAIST, NYU와 인공지능 분야 국내 최초 공동학위제 추진 (0) | 2024.09.09 |

|---|---|

| 머신러닝으로 전기자동차 배터리 열폭주 시점 예측한다 (0) | 2024.09.05 |

| 서큘러스, 생성형 AI 솔루션 '캔버스-온' 출시 (2) | 2024.09.05 |

| KAIST, 딥러닝 대부 요슈아 벤지오 교수와 AI 연구센터 설립 (1) | 2024.09.04 |

| 지브라 테크놀로지스, 머신 비전 플랫폼 '오로라'에 고급 AI 기능 탑재 (1) | 2024.09.02 |