美 코넬대 연구팀은 로봇이 ‘사용법 동영상(how-to video)’을 보고, 단번에 학습할 수 있는 인공지능 기반 로봇 프레임워크인 ‘라임(RHyME·Retrieval for Hybrid Imitation under Mismatched Execution)’을 개발했다고 22일(현지 시각) 밝혔다.

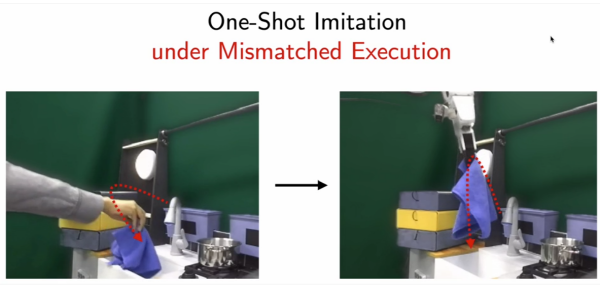

라임은 '구현(embodiment)'과 '실행(execution)'이 불일치하는 휴먼 비디오에서 원샷 모방(one-shot imitation) 학습을 가능하게 한다.

연구팀에 따르면, 지금까지 로봇은 까다로운 학습자에 속했다. 기본적인 작업을 수행하기위해 단계별로 정확한 지침을 요구했으며, 작업 도중에 공구를 떨어뜨리거나 나사를 잃어버리는 등 예상치못한 상황이 벌어지면 작업을 중단하는 경향이 있었다. 인간 시연은 로봇이 장시간의 조작 작업을 수행하도록 프로그래밍하는 강력한 방법이지만 이러한 데모를 로봇이 실행할 수 있는 동작으로 변환하는 데는 동작 스타일과 신체적 능력의 불일치로 인해 상당한 어려움이 있었다.

이번에 개발한 ‘라임’은 로봇 시스템을 훈련하는 데 필요한 시간, 에너지, 비용을 크게 줄여 로봇 시스템의 개발과 배포를 빠르게 진행할 수 있다고 연구팀은 밝혔다.

컴퓨터 과학 분야의 박사 과정 학생인 쿠샬 케디아(Kushal Kedia)는 “로봇으로 작업할 때 성가신 일 중 하나는 로봇이 다양한 작업을 수행하면서 많은 데이터를 수집하는 것이다. 사람은 그런 식으로 작업을 수행하지 않는다. 우리는 다른 사람들을 영감의 원천으로 삼는다”라고 말했다.

연구팀은 오는 5월 애틀랜타에서 열리는 IEEE 로봇 및 자동화 국제 컨퍼런스(ICRA 2025·International Conference on Robotics and Automation)에서 논문을 발표할 예정이다.(논문 제목:One-Shot Imitation under Mismatched Execution)

라임은 로봇 시스템이 자체 메모리를 사용해 한번 영상으로 시청한 작업을 수행할 때 이미 본 동영상을 바탕으로, 작업을 수행하도록 로봇 시스템을 강화할수 있다. 예를들어, 사람이 카운터에서 머그잔을 가져와 근처 싱크대에 놓는 동영상을 본 라임 장착 로봇은 동영상 뱅크를 검색하여 컵을 잡고 식기를 내리는 등 유사한 동작에서 영감을 얻는다.

라임은 로봇이 여러 단계의 시퀀스(multiple-step sequences)를 학습할 수 있는 길을 열어주는 동시에, 훈련에 필요한 로봇 데이터의 양을 크게 줄여준다고 연구팀은 말했다. 라임은 30분 분량의 로봇 데이터만 필요하며, 실험실 환경에서 이 시스템을 사용하여 훈련된 로봇은 이전 방법에 비해 작업 성공률이 50% 이상 증가했다고 연구팀은 밝혔다.

장길수 ksjang@irobotnews.com

<저작권자 © 로봇신문사 무단전재 및 재배포금지>

'인공지능' 카테고리의 다른 글

| ‘서울대-CMU 인간중심 인공지능 연구센터', 올해 4개 프로젝트 추진한다 (1) | 2025.04.29 |

|---|---|

| 마음AI, SK산하 로봇 브랜드 ‘나무엑스’에 ‘온디바이스 AI’기술 공급 (0) | 2025.04.29 |

| '젊은 로봇 공학자' (80) 국립한밭대학교 현장훈 교수 (0) | 2025.04.22 |

| 메디팜소프트, '심방세동 조기진단 예측 시스템' 식약처 허가 받아 (1) | 2025.04.21 |

| [IP Daily]“TV 프로그램 배정 AI, 특허 안돼" (0) | 2025.04.21 |